DenseAV теперь может понимать значение слов и предложений по видео

Инновационный алгоритм DenseAV, разработанный в Массачусетском технологическом институте, обучается пониманию смысла слов и фраз путем анализа видеозаписей с участием людей.

Данный алгоритм продемонстрировал более высокие результаты по сравнению с другими моделями в задачах распознавания объектов по их наименованию.

Специалисты решили модернизировать инновационный подход к изучению языка, который не требует ввода текста. Вместо этого их методика основана на наблюдении за тем, как дети усваивают язык, воспринимая окружающий мир.

Ключевая идея разработанной ими модели DenseAV заключается в том, что она способна предсказывать, что, к примеру, может видеть человек, исходя из того, что он слышит в ту или иную минуту, и наоборот. Например, если человек слышит фразу «выпекайте пирог при 350 градусах», модель сможет предположить, что он, скорее всего, видит изображение торта или духовки.

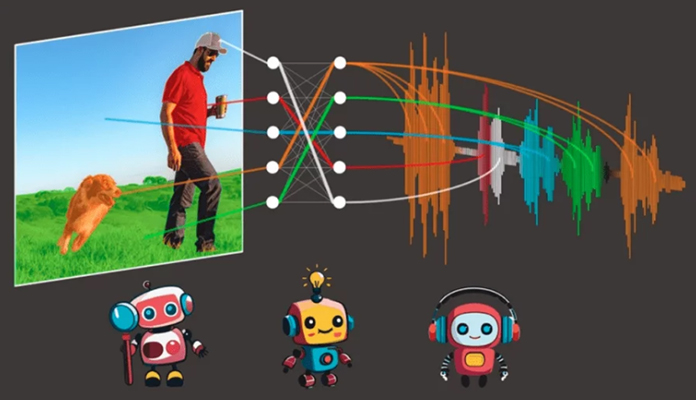

DenseAV – это инновационный алгоритм, который использует два отдельных компонента для обработки аудио- и визуальных данных. Такой подход позволяет алгоритму эффективно распознавать объекты и формировать детальные, содержательные признаки как для звуковых сигналов, так и для визуальных.

В процессе обучения DenseAV сопоставляет и объединяет все возможные соответствия между аудиоклипами и визуальными элементами изображений. Это дает возможность алгоритму глубоко анализировать и понимать взаимосвязь между аудио- и видеоданными.

Алгоритм был обучен на внушительном наборе данных AudioSet, включающий в себя около 2 миллионов видеороликов с Ютуба. Чтобы всесторонне оценить возможности модели, исследователи также создали дополнительные тестовые датасеты. В ходе этих испытаний модель DenseAV продемонстрировала превосходство над существующими передовыми решениями в области связывания звуков и изображений.

Последние новости:

- Apple представит Siri на базе Gemini от Google в феврале 2026 года

- Как изменить адрес электронной почты Gmail: пошаговая инструкция и лимиты

- Астрофизик Ави Леб нашел частицы рекордного размера в антихвосте межзвездной кометы

- Астрофизик Ави Леб назвал 12 признаков искусственного происхождения объекта 3I/ATLAS

- Число авторов VK Видео удвоилось: платформа стала лидером по аудитории в России